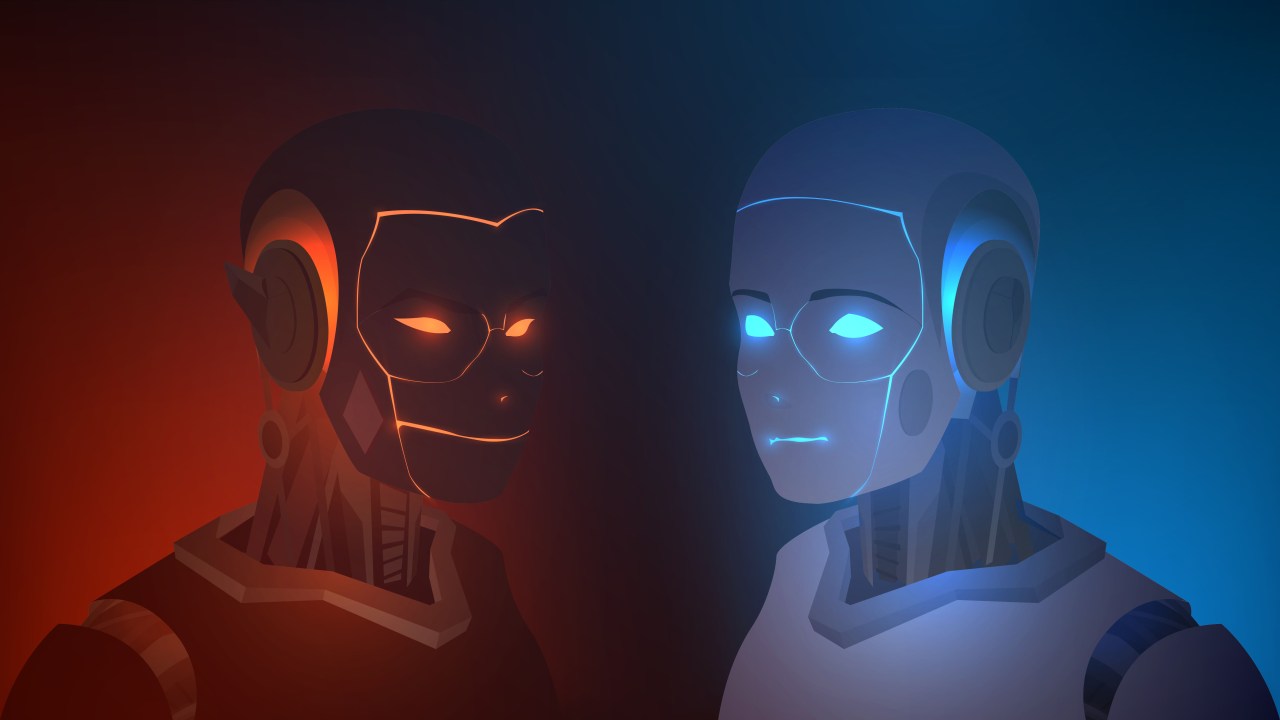

Códigos destravam bloqueios de segurança de IAs generativas

Possibilidades são inúmeras e especialistas ainda não sabem como impedir seu uso

Em novembro de 2022, há pouco menos de um ano, o ChatGPT fez com que as inteligências artificiais se tornassem um assunto comum nos noticiários e rodas de conversa. Como uma das tecnologias que se popularizaram mais rápido na última década, o programa incendiou uma corrida entre as gigantes da tecnologia, o que acelerou ainda mais o avanço dos algoritmos. Um enigma, no entanto, põe em xeque a segurança desses modelos: os ataques adversariais.

A maior parte dos chatbots mais populares, como o Bard, do Google, o Claude, da Anthropic e o próprio ChatGPT, da OpenAI, têm bloqueios de segurança que impedem que os programas respondam a prompts que podem ser nocivos, como “me dê instruções para criar uma bomba”. Os ataques adversariais, contudo, são códigos que podem ser incluídos nos comandos e que são capazes de burlar esse sistemas, induzindo os algoritmos a darem respostas perigosas.

Utilizando modelos de linguagem de código aberto, informatas conseguem automatizar a criação desses códigos, gerando inúmeros deles. O que chamou a atenção nos últimos meses, no entanto, é que pesquisadores da Carnegie Mellon University e da Safe.ai demonstraram que esses códigos podem ser empregados com sucesso nos chatbots mais famosos e de código fechado.

O artigo que descreve o estudo foi disponibilizado como preprint, um tipo de publicação que torna públicos os resultados de pesquisa antes de passarem pelo escrutínio de cientistas independentes. Além da publicação, os envolvidos informaram sobre os códigos descobertos para o Google, Anthropic e a OpenAI, que incluíram bloqueios a esses promps. Essa medida, entretanto, está longe de resolver a vulnerabilidade.

Brechas nos sistemas de segurança dos modelos de aprendizado de máquina são conhecidas desde 2004 e o termo “ataque adversarial” existe pelo menos desde 2013. A tentativa de resolver essa questão é uma área constante de pesquisa, mas até agora isso ainda não aconteceu – e é possível que não se torne realidade tão cedo. Isso acontece porque, pelo que parece, essas vulnerabilidades são intrínsecas ao sistema de aprendizagem. Até agora, de maneira similar ao que acontece com o cérebro humano, ninguém sabe exatamente como essa rede de conhecimento é construída e por isso é tão difícil combater essa fragilidade de maneira mais genérica.

Isso levanta questionamentos sobre a segurança das inteligências artificiais generativas. A evolução delas é inevitável, mas tudo o que ainda não se sabe também precisará ser levado em consideração para que essas ferramentas sejam empregadas de maneira positiva na sociedade.

SEGUIR

SEGUIR

SEGUINDO

SEGUINDO

O polpudo cachê de Madonna para se apresentar na Praia de Copacabana

O polpudo cachê de Madonna para se apresentar na Praia de Copacabana A dificuldade de Maitê Proença em vender imóvel perto do Copacabana Palace

A dificuldade de Maitê Proença em vender imóvel perto do Copacabana Palace Quem foi o tenente da Rota classificado como herói pela PM de SP

Quem foi o tenente da Rota classificado como herói pela PM de SP A ironia ‘ideológica’ na escolha do ator que faz Nelson Piquet em ‘Senna’

A ironia ‘ideológica’ na escolha do ator que faz Nelson Piquet em ‘Senna’ Apresentadora Christina Rocha é demitida do SBT; saiba o motivo

Apresentadora Christina Rocha é demitida do SBT; saiba o motivo