“Máquinas similares às hoje existentes serão construídas a custos mais baixos, mas com velocidades mais rápidas de processamento.” Assim, em um artigo de 1965, o empreendedor americano Gordon Moore, cofundador da Intel e hoje com 90 anos de idade, apresentou sua célebre ideia. Pela “Lei de Moore”, a cada cerca de dois anos o desempenho dos chips de computador dobra, sem que aumentem os custos de fabricação. A máxima, irretocável, à exceção de pequenos detalhes de percurso, funcionou tal qual intuíra Moore — e as máquinas evoluíram no ritmo imaginado por ele. É uma regra que pode estar com os dias contados. Vive-se, hoje, uma revolução tecnológica afeita a deixar no passado o raciocínio da duplicação de capacidade de cálculos à base de silício: é a computação quântica. Ela poderá nos levar a distâncias inimagináveis: tarefas que o computador mais poderoso do planeta demoraria 10 000 anos para completar seriam feitas em pouco mais de três minutos (veja o quadro).

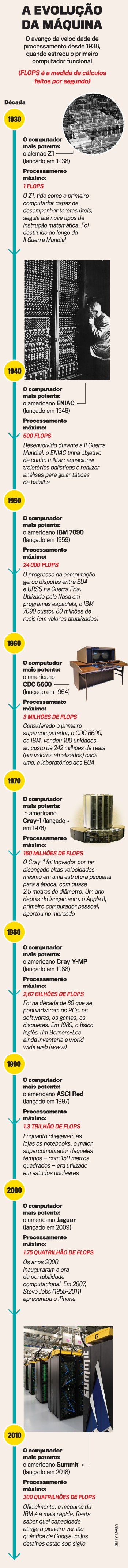

A computação quântica era uma construção que, até o início desta década, não passava de teoria impressa em estudos universitários. Nos últimos anos, começou a ser testada na prática, com sucesso apenas parcial, até conseguir tração que, finalmente, parece se encaminhar para uma nova história. Um documento da Google, vazado recentemente, mostra que a empresa, que nasceu como um motor de buscas para depois invadir outras searas, pode estar muito próximo de romper de vez com o paradigma imposto pela Lei de Moore ao criar o primeiro computador quântico funcional da história.

A revelação foi resultado de uma distração. Algum funcionário da Nasa, também envolvido com o projeto, acidentalmente publicou, em 20 de setembro, no site da agência espacial americana, um estudo que mostra o feito da Google, realizado por meio de uma máquina, ainda sob sigilo, nomeada como Sycamore. O arquivo, programado para ser divulgado oficialmente neste mês, permaneceu poucos segundos no ar — mas foi o bastante para ser flagrado pelo jornal inglês Financial Times. O supercomputador cumpriu um feito inédito: estabilizou os chamados qubits (versões quânticas dos tradicionais bits) por tempo suficiente para que fossem realizadas operações pela inteligência artificial.

A inovação do gigante americano da internet pode dar fim ao paradigma da Lei de Moore, que estabelecia um progresso sempre constante para os chips

Exige-se, aqui, uma breve pausa para explicar a computação quântica. Em um PC regular, os chips operam por meio de bits, unidades binárias responsáveis por formar a linguagem dos softwares. Esses bits regem os cálculos sempre como se desempenhassem um de dois papéis, dentro da ideia da língua das máquinas: ou são “zero” ou são “1”. No caso do qubit dá-se um comportamento simultâneo, com o “zero” e o “1” ao mesmo tempo. Grosso modo, seria como se um ser humano pudesse, ao mesmíssimo tempo, de modo correto e com perfeita dicção, falar duas palavras. Na prática, representa a possibilidade de um salto gigantesco na velocidade dos computadores.

O computador secreto da Google foi pioneiro ao efetivar essa ambição. O avanço ainda se restringe a âmbitos estritamente técnicos, sem utilidade cotidiana. Já é, porém, apelidado de “o Santo Graal da computação”. Isso porque o feito, se comprovado, atingiu o que se conhece como “supremacia quântica”. A nomenclatura indica aquele momento da civilização em que os computadores seriam tão (ou mais) competentes quanto os seres humanos. O cientista da computação americano Scott Aaronson, professor da disciplina de informação quântica na Universidade do Texas em Austin (EUA), diz, em entrevista a VEJA: “Isso não causará mudança imediata na vida das pessoas. Mas só por enquanto, pois se trata do início de um caminho que levará a transformações radicais em diversas áreas, culminando certamente no desenvolvimento de inovações que devem abranger de novos remédios à criação de materiais artificiais com atributos que hoje se restringem à imaginação”. Vale lembrar que o computador que usamos hoje também começou com um passo singelo, em 1843, quando a matemática inglesa Ada Lovelace (1815-1852) publicou um diagrama numérico que veio a ser considerado o primeiro algoritmo computacional. Foi esse trabalho, então estritamente técnico, que permitiu, quase dois séculos depois, a existência de notebooks, smartphones, tablets, robôs etc.

Publicado em VEJA de 6 de outubro de 2019, edição nº 2655

O passado criminoso de um dos maiores campeões da música pop dos anos 80

O passado criminoso de um dos maiores campeões da música pop dos anos 80 As dívidas do homem que explodiu bombas na frente do STF

As dívidas do homem que explodiu bombas na frente do STF Banco rebaixa classificação do Brasil e aumenta aposta na Argentina

Banco rebaixa classificação do Brasil e aumenta aposta na Argentina A Geração Z está trocando o Spotify por uma tecnologia retrô

A Geração Z está trocando o Spotify por uma tecnologia retrô A data mais esperada pelos fãs de novelas entediados com ‘Mania de Você’

A data mais esperada pelos fãs de novelas entediados com ‘Mania de Você’