Inteligência artificial pode reproduzir racismo, homofobia e misoginia

Softwares guiados por algoritmos que buscam simular o comportamento humano acabaram por repetir o que há de pior em nós: a discriminação contra o outro

Dez anos depois que o naturalista inglês Charles Darwin (1809-1882) apresentou a revolucionária Teoria da Evolução no clássico A Origem das Espécies (1859), um primo seu usou a ideia para germinar outro conceito, este perigosíssimo. Tratava-se do médico Francis Galton (1822-1911), que viu na Teoria da Evolução uma indicação de que haveria humanos mais naturalmente “evoluídos” do que outros. Segundo a proposta de Galton, seria possível, ao analisar tão somente a aparência física das pessoas, agrupá-las de acordo com padrões e, em sequência, determinar o comportamento e as capacidades de cada uma. Os trejeitos que resultassem em “pessoas indesejadas” poderiam ser excluídos por meio da seleção artificial, o que permitiria aos “indivíduos notáveis” manter sua descendência. Galton batizou essa nova ciência (a rigor, pseudociência) de eugenia. A ideia ganhou popularidade no fim do século XIX e depois cairia nas graças dos nazistas, que reivindicavam para os arianos a condição de “raça superior”. Isso tudo é história, mas hoje surge o dado perturbador: depois que a ciência, em especial a genética — que demonstrou que não existe base para o conceito de raça humana e que um negro pode ter o DNA mais similar ao de um branco do que dois “arianos” entre si —, demoliu os postulados fajutos de Galton, agora os robôs do século XXI demonstram predileções que poderiam ser chamadas de eugenistas. Ponta de lança dos avanços tecnológicos, a inteligência artificial (IA) não está livre de emular os mais estúpidos preconceitos humanos, como atestam exemplos coletados pelo menos desde 2015 (veja o quadro ao lado).

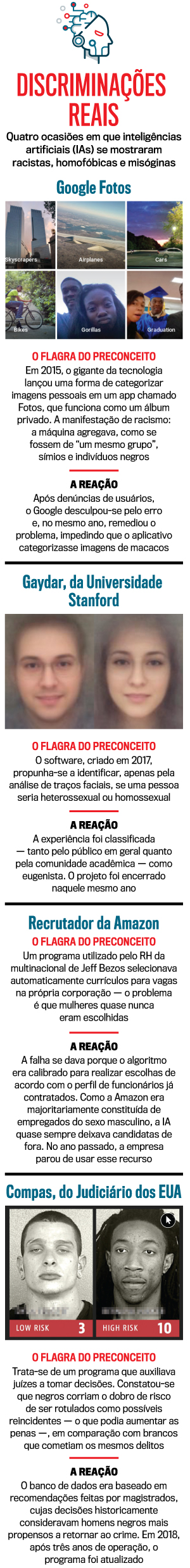

Racismo, misoginia, homofobia — programas inteligentes são capazes de exercer todo tipo de preconceito. Um episódio emblemático foi o do americano Jacky Alciné, que sentiu na pele o racismo expresso por um robô — no caso, o aplicativo Fotos, da Google. Trata-se de um programa que se propõe a compilar, por meio de um algoritmo, imagens salvas em um celular. A IA agrupa fotos de acordo com categorias como “pessoas”, “viagens”, “pets”. O susto: a máquina colocou retratos de Alciné, que é negro, no mesmo grupo de “gorilas”. “Como sou programador de softwares, sei qual é a raiz do problema. A base de dados é criada por humanos. Certamente foram esses profissionais que, ao desenhar o algoritmo, inseriram padrões que associaram negros a gorilas”, relatou o americano em entrevista a VEJA.

A origem dessas aberrações está, quase sempre, em erros na calibragem dos algoritmos. Os softwares são guiados por códigos, que são desenvolvidos por humanos; quando essas informações são enviesadas (ainda que o programador não o perceba), levam à fabricação de robôs racistas. Ou machistas: no ano passado, por exemplo, a Amazon foi acusada por ex-funcionários, em relatos anônimos à Reuters, de ter se apoiado em um software misógino na seleção de pessoal. Constatou-se que o sistema havia sido treinado com base na análise de contratações anteriores. O problema é que a maioria dos empregados da Amazon é do sexo masculino. Por isso o programa privilegiava homens.

Talvez não seja possível monitorar as predileções de cada programador para impedir o desenvolvimento de robôs hostis. Assim a solução que tem ganhado força é a formulação de leis que exigem limites às IAs. Em maio de 2018, a União Europeia implementou uma lei que obriga as empresas por trás dos algoritmos a receber reclamações de indivíduos que se sentiram lesados diante de julgamentos automáticos feitos por softwares. Em dezembro, a cidade de Nova York aprovou uma legislação que torna obrigatório às agências públicas explicar o funcionamento dos algoritmos que utilizam. O risco do preconceito exercido por inteligências artificiais é insidioso, pois parece impessoal. Como bem definiu o historiador israelense Yuval Harari em entrevista a VEJA no ano passado: “A discriminação no mundo real permite que um grupo se revolte. Mas o algoritmo pode discriminar só por discriminar. Há algo específico sobre você de que a IA não gosta, e você nem sabe o que é”.

Publicado em VEJA de 24 de julho de 2019, edição nº 2644

SEGUIR

SEGUIR

SEGUINDO

SEGUINDO

As reações de atrizes veteranas à fala de Regina Duarte na TV Globo

As reações de atrizes veteranas à fala de Regina Duarte na TV Globo CCJ deu resposta imediata à decisão de Gilmar sobre impeachment de ministros do STF

CCJ deu resposta imediata à decisão de Gilmar sobre impeachment de ministros do STF Greve dos caminhoneiros é até agora um grande fracasso em todo o país

Greve dos caminhoneiros é até agora um grande fracasso em todo o país Ações da Anvisa proíbem suplemento de ora-pro-nóbis, vinagre de maçã e produtos com creatina

Ações da Anvisa proíbem suplemento de ora-pro-nóbis, vinagre de maçã e produtos com creatina O que se sabe sobre a greve de caminhoneiros convocada para quinta-feira

O que se sabe sobre a greve de caminhoneiros convocada para quinta-feira