Saiba como identificar deepfakes, a nova fronteira das notícias falsas

Cada vez mais popular, técnica que usa inteligência artificial para produzir falsificações em vídeo desperta para o risco que representa ao jogo democrático

Começa sempre como uma brincadeira até que alguém tem a péssima ideia de levá-la a sério com interesses que não têm a menor graça. Este foi o roteiro percorrido pelas fake news e agora é repetido em uma nova fronteira, com potencial de estrago ainda maior: as deepfakes. A técnica que usa inteligência artificial para inserir rostos em personagens com o objetivo de criar uma falsificação em vídeo para alguém dizer algo que não disse começou a se popularizar em 2017, quando celebridades passaram a ter suas imagens inseridas em cenas de filmes pornográficos.

No Brasil, as montagens ficaram populares neste ano por obra do editor de vídeo, jornalista e estudante de Direito Bruno Sartori, que caiu nas graças da internet tirando sarro do presidente Jair Bolsonaro (PSL) e do ministro Sergio Moro (PSL) em “papéis” como o do Chapolin Colorado ou da cantora Kelly Key. A rapidez com que a técnica se desenvolve e fica acessível, entretanto, já acendeu o sinal de alerta de empresas de tecnologia como Facebook e Microsoft, que investem em pesquisas para o desenvolvimento de ferramentas para identificar as falsificações.

O Google também se mexe. O gigante das buscas disponibilizou no final de setembro um banco de dados público com milhares de imagens para serem utilizadas em pesquisas para detecção destas lorotas audiovisuais. “Acreditamos firmemente no apoio a uma comunidade de pesquisa próspera para mitigar os potenciais danos causados pelo uso indevido de mídia sintética”, afirmou a companhia em um comunicado.

A um ano das eleições municipais, o risco imediato é o uso das deepfakes para tumultuar o processo democrático com conteúdos feitos sob medida para prejudicar adversários — o que é proibido. “A falta de capacidade em compreender os conteúdos recebidos nas mídias sociais somada ao desejo de provar a corrupção de quem está do outro lado do espectro político em um ambiente polarizado faz com que o Brasil seja um cenário ideal para que esse tipo de conteúdo gere muita confusão”, avalia o advogado Carlos Affonso Souza, diretor do Instituto de Tecnologia e Sociedade (ITS).

Ele recorda o vídeo íntimo atribuído ao então candidato ao governo de São Paulo João Doria (PSDB) durante a campanha de 2018 como um “aperitivo” do que vem por aí. O advogado alerta, porém, que o controle deste novo fenômeno não pode resvalar em censura nem impedir o desenvolvimento de novas tecnologias. “Não é com uma lei para criminalizar as deepfakes que este problema vai ser superado”, afirma. Além das plataformas, ele cobra uma educação do público e sua atuação para combater as mentiras: “Ser o chato do grupo de WhatsApp é um dever cívico”.

Responsável pelas montagens que viralizam zombando do presidente Bolsonaro, seus filhos ou o ministro Moro, Sartori afirma já ter sido assediado por partidos políticos interessados em suas habilidades no ano que vem, mas que pretende produzir conteúdos educativos que auxilie os eleitores a se precaverem contra as deepfakes. Ele se limita a produzir vídeos de sátira, em que o contexto absurdo afasta qualquer dúvida sobre a intenção humorística. Seu canal no YouTube contabiliza mais de 1,7 milhão de visualizações — fora o que é compartilhado no WhatsApp. Autodidata na técnica há menos de dois anos, ele reconhece o potencial danoso das montagens e preocupa-se com a velocidade com que ela evolui de modo a tornar as falsificações cada vez mais verossímeis.

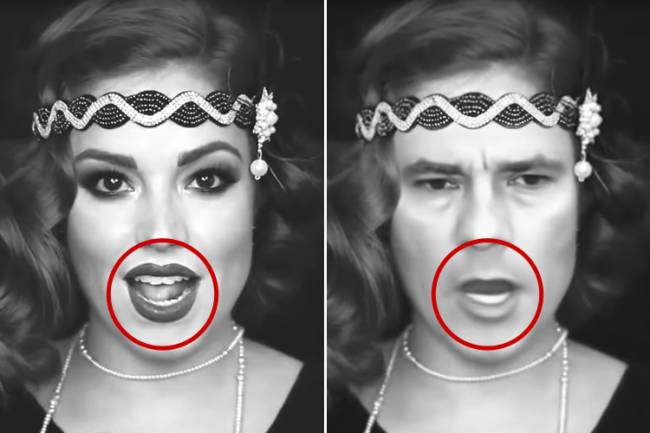

Há, entretanto, alguns sinais que permitem a identificação de deepfakes, já que o trabalho de inteligência artificial necessita de um ajuste fino por um ser humano. Ausência de separação entre os dentes, olhares para direções diferentes ou “descolamento” do rosto que permitem a duplicação de sobrancelhas são alguns dos problemas mais comuns. “A informação é a única arma que temos. Se as pessoas não forem informadas das possibilidades dessa tecnologia, estaremos perdidos nas próximas eleições”, diz.

Veja algumas dicas de como identificar deepfakes:

Flávio revela reação de Tarcísio após anúncio de disputa à Presidência

Flávio revela reação de Tarcísio após anúncio de disputa à Presidência Virginia vira piada na Grande Rio ao desfilar colada no professor de samba

Virginia vira piada na Grande Rio ao desfilar colada no professor de samba Lula ganha um novo presente da direita, mas o futuro indica um desafio quase impossível

Lula ganha um novo presente da direita, mas o futuro indica um desafio quase impossível ‘Dark Horse’, filme sobre Bolsonaro, tem primeiras cenas divulgadas; assista ao teaser

‘Dark Horse’, filme sobre Bolsonaro, tem primeiras cenas divulgadas; assista ao teaser Como vai ficar o tempo em São Paulo e em outras capitais no começo da semana?

Como vai ficar o tempo em São Paulo e em outras capitais no começo da semana?